Περιεχόμενα

Δεν έχουν περάσει ούτε δέκα μήνες από τότε που το ChatGPT μπήκε στη ζωή μας. Η «ανακάλυψη» του OpenAI, ένα chatbot που «σκέφτεται» πριν δώσει απάντηση και μπορεί να συνομιλήσει άνετα μαζί μας και να μας βοηθήσει, έχει γίνει εργαλείο στα χέρια εκατοντάδων εκατομμυρίων ανθρώπων. Κι ακόμα, όπως λένε οι ειδικοί, είμαστε μόνο στην αρχή: Το διαδίκτυο, η τεχνολογία, ο τρόπος που αναζητούμε και επεξεργαζόμαστε πληροφορίες, όλα πρόκειται να αλλάξουν.

Το πράγμα κινείται με τέτοιους ιλιγγιώδεις ρυθμούς, που πλέον έχει ξεφύγει από τον απλό πειραματισμό. Πολλοί χρήστες κινήθηκαν με περιέργεια μάλλον παρά ανάγκη από κάποιον να τους βοηθήσει. Αυτή η παράξενη αίσθηση, ότι γνωρίζεις πως συνομιλείς με μια μηχανή και τεστάρεις την αντίληψή της, είναι κάτι ασυναγώνιστο. Ως τώρα, βέβαια. Διότι στη συνέχεια, όταν απομυθοποιηθεί αυτή η επικοινωνία, θα ξεχωρίσει τι μπορεί πραγματικά να κάνει το ChatGPT και τα διάφορα άλλα chatbots τεχνητής νοημοσύνης για να βοηθήσουν την καθημερινότητά μας.

Μέχρι στιγμής, οι χρήστες έχουν προστρέξει στο ChatGPT για να βελτιώσουν την προσωπική τους ζωή και να ενισχύσουν την παραγωγικότητα. Μερικοί εργαζόμενοι έχουν αρχίσει ήδη να χρησιμοποιούν το chatbot για να αναπτύξουν κώδικα, να γράψουν λίστες ακινήτων και να δημιουργήσουν σχέδια μαθημάτων. Άλλοι έχουν βασίσει την επαγγελματική τους καριέρα στη διδασκαλία των καλύτερων τρόπων χρήσης του ChatGPT.

Για τους απαιτητικούς, ήδη κυκλοφορεί το ChatGPT Plus. Ένα Expedia μπορεί να σας βοηθήσει να κλείσετε ένα ταξίδι, ενώ ένα OpenTable θα σας κάνει κράτηση για δείπνο. Μόλις τον περασμένο μήνα, το OpenAI κυκλοφόρησε το Code Interpreter, μια έκδοση του ChatGPT που μπορεί να κωδικοποιεί και να αναλύει δεδομένα.

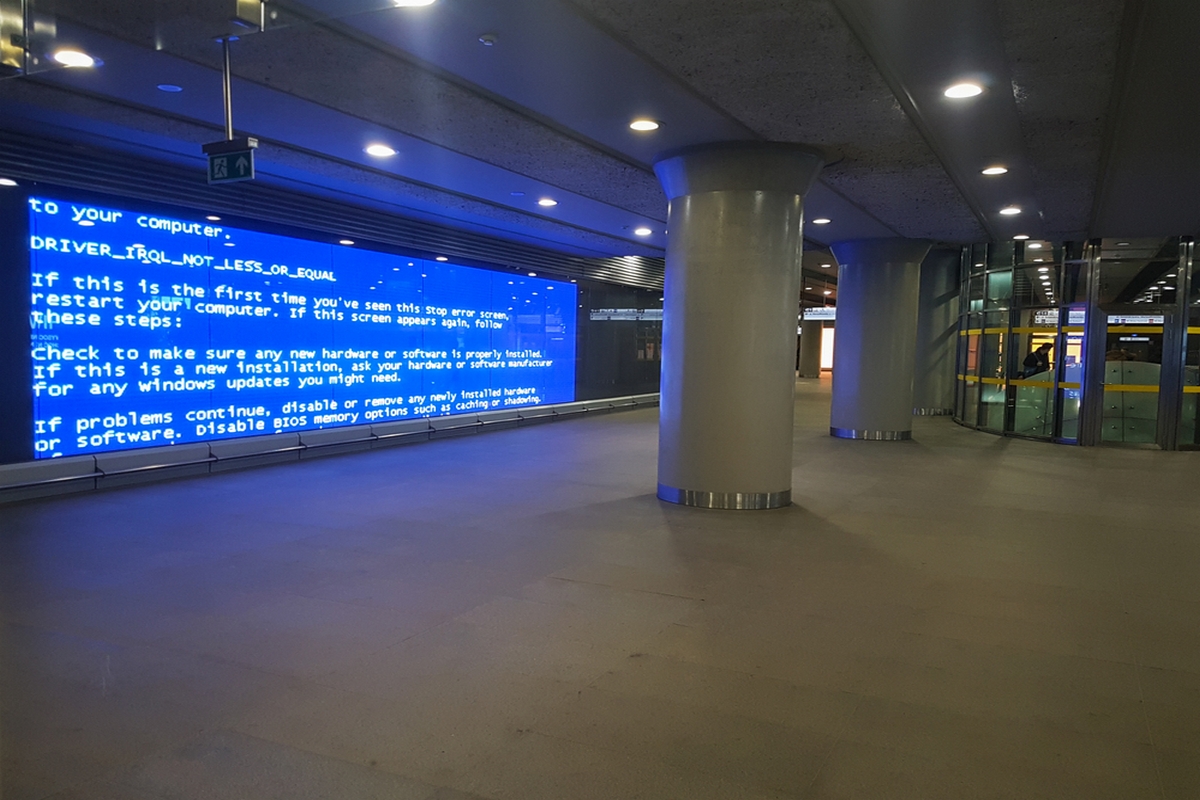

Πειραματικό το ChatGPT, πραγματικά τα λάθη

Εδώ τελειώνουν τα καλά νέα. Κι αρχίζουν τα παρατράγουδα.

Δεν υπάρχει αμφιβολία ότι οι ειδικοί της τεχνητής νοημοσύνης φωνάζουν σε όλους τους τόνους ότι πρόκειται για ένα πειραματικό στάδιο. Όπερ σημαίνει… συγχωρήστε τα λάθη τα δικά μας και των εφαρμογών μας, μαθαίνουμε απ’ αυτά, γινόμαστε καλύτεροι. Κοινώς, μη βασίζεστε και απόλυτα πάνω σ’ αυτά που σας λέμε, αλλιώς θα έχετε προβλήματα. Απαραίτητη διευκρίνιση αυτή, ώστε τα διάφορα chatbots να μην έχουν προβλήματα ούτε με τη νομοθεσία ανά κράτος, ούτε και με ηθικούς κώδικες, που είναι ακόμα πιο περίπλοκοι.

Κατ’ αρχάς, υπάρχει το θέμα της «τεχνητής ομιλίας». Μια συνομιλία με το ChatGPT μπορεί να δημιουργήσει την ψευδαίσθηση ότι συνομιλεί κάποιος με κάτι που σκέφτεται. Αλλά δεν γίνεται αυτό. Στην ουσία, η εφαρμογή λειτουργεί με «εργαλεία μοντέλων μεγάλων γλωσσών». Ο υπολογιστής ταιριάζει λέξεις και φράσεις, ανάλογα με την περίσταση. Δεν σκέφτεται.

Αυτό σημαίνει ότι, παρόλο που το ChatGPT μπορεί να εξηγήσει την κβαντική φυσική ή να γράψει ακόμα και ένα ποίημα με τις λέξεις που θα του δώσουμε σαν κατεύθυνση, απέχει ακόμα πολύ από την διαδικασία της «σκέψης», όπως τη βιώνουμε εμείς. Αν την κατακτήσει ποτέ.

Υπάρχει μια παροιμία που είναι πολύ δημοφιλής ανάμεσα στους επιστήμονες αυτού του τομέα: «Ένας άπειρος αριθμός πιθήκων θα σας δώσει τελικά τον Σαίξπηρ». Με λίγα λόγια, η εξέλιξη μπορεί να είναι αναπόφευκτη, αλλά δεν μπορεί να προσδιοριστεί χρονικά. Για την ώρα υπάρχει μεγάλη διαφορά μεταξύ του τρόπου με τον οποίο οι άνθρωποι παράγουν γλώσσα και του τρόπου που το κάνουν τα μεγάλα γλωσσικά μοντέλα.

Τα chatbots όπως το ChatGPT τροφοδοτούνται από μεγάλες ποσότητες δεδομένων και υπολογιστικών τεχνικών για να κάνουν προβλέψεις για να συνδυάσουν λέξεις με ουσιαστικό τρόπο. Όχι μόνο αξιοποιούν ένα τεράστιο λεξιλόγιο και πληροφορίες, αλλά κατανοούν και λέξεις στο πλαίσιο. Αυτό τους βοηθά να μιμούνται μοτίβα ομιλίας, αλλά μέχρι εκεί.

Η ψευδαίσθηση, βέβαια, που δημιουργείται είναι κάτι που πρέπει να απασχολήσει τους επιστήμονες της ψυχικής υγείας στο άμεσο μέλλον. Αλλά προηγουμένως πρέπει να λυθούν κάποια πιο πρακτικά θέματα.

Τσουνάμι παραπληροφόρησης

Έχουν ήδη αρχίσει να κινούνται διαδικασίες για ζητήματα που η OpenAI προσπαθεί επιμελώς να αποσύρει από την επικαιρότητα: ένα τσουνάμι παραπληροφόρησης, κλοπή προσωπικών δεδομένων για εκπαιδευτικούς σκοπούς, ακόμη και ενθάρρυνση των μαθητών να εξαπατήσουν και να λογοκλοπή στις εργασίες τους. Σε ορισμένες περιπτώσεις, μάλιστα, τα πράγματα έχουν πάρει τη νομική οδό. Έχουν υποβληθεί μηνύσεις.

Κατ’ αρχάς, η παραπληροφόρηση. Όσοι είστε έστω και ευκαιριακοί χρήστες των social media αποκλείεται να μην παρατηρήσατε στο timeline σας ένα screenshot κάποιου φίλου σας, διαδικτυακού ή μη, που ζήτησε από το ChatGPT να του περιγράψει το βιογραφικό του και κατέληξε μ’ ένα σωρό ανακριβείς και λανθασμένες πληροφορίες. Σε χιουμοριστικό επίπεδο, ήταν ασφαλώς χαριτωμένο. Ο καθένας γνωρίζει τι έχει κάνει και τι όχι, για να το συγκρίνει με τις «πληροφορίες» του chatbot και να χαμογελάσει. Τι συμβαίνει, όμως, όταν κάποιος άγνωστος ζητάει πληροφορίες για μας και έρχεται αντιμέτωπος με δεδομένα που είναι εντελώς λανθασμένα;

Μπορεί αυτό να βελτιωθεί; Θεωρητικά, όσο αυξάνονται τα δεδομένα που τροφοδοτούν το chatbot, τόσο πιο ακριβείς πληροφορίες θα μπορεί να δώσει για τον καθένα μας. Από την άλλη, πόσο εφικτό είναι να συγκεντρώσει τρισεκατομμύρια τρισεκατομμυρίων δεδομένα για έναν κόσμο 8 δισεκατομμυρίων ανθρώπων που ολοένα αυξάνεται; Και ποιος μπορεί να πιστοποιήσει ότι η οποιαδήποτε πληροφορία παρέχει θα είναι αληθινή η ψεύτικη;

Πώς θα εφαρμοστεί το GDPR;

Ο γενικός κανονισμός προστασίας δεδομένων (ΓΚΠΔ ή αν προτιμάτε στα αγγλικά GDPR) έχει εισέλθει δραστικά στη ζωή μας τα τελευταία χρόνια. Και πολύ καλά κάνει. Η προστασία των προσωπικών μας δεδομένων είναι κάτι σημαντικό, υπάρχει αυστηρή νομοθεσία σχεδόν σε όλες τις ανεπτυγμένες χώρες. Ολοένα και περισσότερος κόσμος κατανοεί πόσο σημαντικό είναι να έχουν πρόσβαση στα προσωπικά του δεδομένα μόνο οι απολύτως απαραίτητοι.

Το ChatGPT στην ουσία αυτό το καταστρατηγεί. Και ερήμην μας. Με το να αποθηκεύει πληροφορίες, φωτογραφίες, ημερομηνίες, τοποθεσίες και οτιδήποτε άλλο «τροφοδοτούμε» τους προσωπικούς μας λογαριασμούς κυρίως στα μέσα κοινωνικής δικτύωσης, έχει σκοπό να χρησιμοποιήσει αυτά τα δεδομένα για να χτίσει όσο πιο πολλά προφίλ μπορεί. Πώς θα τα βγάλει πέρα, όμως, με τις νομικές ρυθμίσεις, που απαιτούν ακόμα και όταν επιτρέπεται να αποθηκεύονται προσωπικά δεδομένα, αυτά να διαγράφονται μετά από σχετικά μικρό χρονικό διάστημα; Ήδη η Microsoft έχει προειδοποιήσει τους υπαλλήλους της να μην μοιράζονται «ευαίσθητα δεδομένα» με τέτοιες εφαρμογές.

Ωθεί τους φοιτητές στη λογοκλοπή

Σύμφωνα με κάποιες έρευνες, άτυπες ακόμα, η πρώτη σε δημοφιλία χρήση του ChatGPT είναι η λογοκλοπή! Πολλοί φοιτητές εκμεταλλεύονται την άνεση διατύπωσης της εφαρμογής και τη χρησιμοποιούν για να γράψουν ολόκληρες εργασίες για πτυχίο, μεταπτυχιακό τίτλο, ακόμη και ντοκτορά. Η εφαρμογή βεβαίως και ετοιμάζει αυτά τα κείμενα, αλλά αντλώντας στοιχεία από ήδη δημοσιευμένα κείμενα, κάτι που προφανώς δεν επιτρέπεται. Γίνεται, όμως, με τέτοιο τρόπο που να μην γίνεται αντιληπτό από τα ήδη υπάρχοντα εργαλεία που «ανιχνεύουν» τη λογοκλοπή. Αρκεί να δώσουμε στην εφαρμογή την εντολή της «διαφορετικής διατύπωσης».

Οι καθηγητές έχουν ήδη αρχίσει να φωνάζουν γι’ αυτό. Για κάποιους η εξαιρετικά επιστημονική διατύπωση σε κάποιες εργασίες είναι φανερό αποτέλεσμα χρήσης chatbot, αλλά δεν μπορούν να το αποδείξουν. Θεωρούν, λοιπόν, ότι η εφαρμογή από μόνη της ωθεί τους φοιτητές να κλέψουν.

Τα ζητήματα, προφανώς, δεν σταματούν εδώ. Υπάρχουν δημοσιεύματα μέχρι και για καθημερινούς ανθρώπους, που ζήτησαν τη βοήθεια του ChatGPT για να γράψουν μια τεκμηριωμένη επιστολή παραίτησης, αλλά η διατύπωση της εφαρμογής τους οδήγησε σε μπλεξίματα (νομικά και οικονομικά) με την πρώην εταιρεία τους.

** Με πληροφορίες από Business Insider.